Steeds vaker hoor je de term data gravity. Het is het vermogen van data om nieuwe data, applicaties en services naar zich toe te trekken. Grote hoeveelheden data verplaats je nu eenmaal niet zo gemakkelijk. Locaties met een hoge data gravity index, zullen alleen maar nog meer data, applicaties en services aantrekken. Dit heeft grote impact op de datacenterstrategie van bedrijven. Waar moeten zij zich op voorbereiden?

Tot een jaar of tien geleden waren bedrijven kritisch welke data ze wel en niet wilden opslaan, want storage was duur. Als er geen duidelijke businesscase of juridische grondslag voor was, dan werd data meteen na gebruik weer weggegooid. De cloud en de technologische ontwikkelingen die het mogelijk maken om meer waarde te halen uit data, heeft die manier van denken veranderd. We slaan nu bijna ongelimiteerd data op. Met allerlei algoritmen gaan we op zoek naar patronen in data die een voorspellende waarde hebben. Zo ontstaan er businesscases die financieel onhaalbaar zouden zijn als opslagcapaciteit en rekenkracht schaars en duur zijn.

Storage wordt duur

“Het punt is: storage en rekenkracht worden weer schaars en duur”, zegt Dave McCrory, VP of Growth bij Digital Reality. “Ik probeer al meer dan tien jaar te begrijpen wat data is. Wat veroorzaakt nu precies het effect dat data wordt aangetrokken tot data? En wat betekent dat voor de hoeveelheid data die bedrijven willen opslaan en verwerken?”

Volgens McCrory hebben we te maken met een Jevons paradox. Toen kolencentrales vanaf 1865 veel efficiënter stroom gingen produceren dan de individuele bedrijven tot dan toe zelf deden, zag William Stanley Jevons dat de energievoorziening geen beperkende factor meer was. Dat was zo’n stimulans voor technologische vooruitgang dat de vraag naar stroom sneller steeg dan het aanbod. Daardoor werd stroom weer net zo schaars als voor de kolencentrales, alleen de productie was verhuisd naar een andere locatie. Van de zelfvoorziening in stroom door individuele bedrijven ging het naar centrale kolencentrales die voor de hele gemeenschap stroom produceerden.

Exact ditzelfde effect treedt nu op bij de cloud. Ook daar zorgden de gemeenschappelijke faciliteiten in eerste instantie voor een overaanbod aan storage en rekenkracht, waardoor de prijzen sterk daalden. Met als gevolg dat er in no-time allerlei nieuwe toepassingen kwamen, zoals IoT, AI, ML. “Je ziet aankomen dat het niet lang meer duurt voor we weer tegen beperkingen gaan aanlopen”, zegt McCrory. “Daar kun je maar beter op voorbereid zijn.”

Data Gravity Score

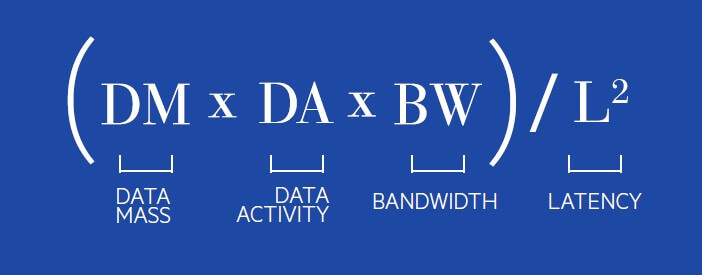

McCrory bedacht een formule om de data gravity van een gebied te berekenen. Data gravity heeft te maken met vier factoren. 1) Hoeveel data is er al op een bepaalde locatie? 2) Wat gebeurt er met die data (de activiteit)? 3) Hoe groot is de bandbreedte van de netwerken op die locatie? 4) Hoe hoog is de latency? Op basis van die vier factoren rolt er de volgende formule uit:

Als je regio’s vergelijkt, dan staat Amsterdam binnen Europa op een derde plaats, met een data gravity-score van 8,54. Dat verbleekt bij de score van Londen, wereldwijd koploper met 167,05. “De datacreatie in Londen ligt namelijk drie keer zo hoog als die in Amsterdam en de opslagruimte is vier keer groter”, verklaart McCrory. New York is in Noord-Amerika koploper met een score van 79,61. Tokio spant in Azië de kroon met 80,32.

Versnippering leidt tot uitdagingen

“Sterker nog, de eerste obstakels worden al bereikt”, zegt Alexandra Schless, CEO van NorthC, met tien locaties marktleider in regionale datacenters in Nederland. “Die worden op dit moment vooral veroorzaakt doordat bedrijven data in verschillende clouds opslaan, waardoor de belangrijkste databronnen fysiek op grote afstand van elkaar staan. Er zit data in SaaS-applicaties zoals Office 365 of Salesforce. Er zijn workloads die op een IaaS-infrastructuur draaien, bijvoorbeeld op Microsoft Azure of Amazon Web Services. En natuurlijk bevindt een groot deel van de data zich nog altijd on-premise of in een private cloud in een extern datacenter. Dat leidt tot drie uitdagingen. Ten eerste is het steeds lastiger om data uit de silo’s te krijgen vanwege de data gravity. Analytics binnen een applicatie, bijvoorbeeld op klantdata in Salesforce, zijn wel mogelijk. Maar als je die klantdata wilt combineren met bijvoorbeeld de ERP-data die in een SAP private cloud staat, moet je hoge kosten maken voor het datatransport en loop je bovendien tegen latency-issues aan. Daarnaast heeft niemand een goed overzicht welke data waar staan. Ook niet als het gaat om privacygevoelige data van klanten of medewerkers. Die bedrijven hebben dus moeite om te voldoen aan de AVG. De derde uitdaging is dat IT-afdelingen nauwelijks kunnen garanderen dat alle (cloud)databases aan dezelfde hoge kwaliteits-, continuïteits- en security-eisen voldoen. Hoeveel organisaties maken bijvoorbeeld een back-up van Office 365?”

Kies je datacenterlocaties zorgvuldig

Daarom is verwerking van al die data in een groot, centraal datacenter niet altijd de beste oplossing. Het is effectiever en voordeliger om een deel van de eerste verwerking van gegenereerde data dichtbij de locatie van de gebruiker te laten plaatsvinden – edge computing – en alleen de resultaten door te sturen voor verdere analyse en opslag. Het rapport ‘De impact van data gravity op IT’ – dat NorthC Datacenters samen met de Dutch Datacenter Association (DDA) heeft uitgebracht – laat zien welke voordelen regionale datacenters bieden voor bedrijven voor lokale dataverwerking. Veel bedrijven zijn dan ook van plan om een deel van hun dataverwerking in een regionaal datacenter of zelfs in een microdatacenter direct op locatie te laten plaatsvinden.

Bij de beslissing welke data je waar opslaat, moet je rekening houden met drie factoren. De eerste is latency. Veel real-time berekeningen zijn dermate latency-gevoelig dat het simpelweg te lang duurt om data eerst naar een cloud te sturen, daar berekeningen uit te voeren en die uitkomsten vervolgens terug te sturen. Denk bijvoorbeeld aan een zelfrijdende auto of aan computergestuurde machines in fabrieken. In die gevallen zul je data ‘at the edge’ moeten verwerken.

Ook netwerkkosten spelen een rol bij de keuze van een datacenterlocatie. Als je alle data voortdurend over grote afstanden moet versturen, lopen die immers snel op. Zeker nu er steeds meer data-intensieve IoT-apparaten worden gebruikt, zoals bijvoorbeeld camera’s die productieprocessen monitoren.

Tot slot heb je te maken met wet- en regelgeving. Met name als de verwerking van data plaatsvindt in een public cloud. Het is namelijk niet altijd wenselijk en soms zelfs onmogelijk om data in een public cloud op te slaan, waarbij onduidelijk is in welk fysiek datacenter die data dan staat. In veel gevallen eist de wet dat de data in Nederland of anders toch ten minste binnen de EU blijft.

Alternatieve concepten

Sommige sectoren zien de problemen met data gravity op zich af komen en werken hard aan alternatieven. Een voorbeeld is het Personal Health Train-concept (PHT) in de zorg (zie ICT/Zorg van augustus 2020). Naast de omvang van de datasets is het in de zorg ook vanwege privacy-issues lastig om data van grote groepen patiënten uit verschillende ziekenhuizen bij elkaar te brengen voor researchdoeleinden. Daarom brengt PHT het algoritme naar de data. Dit concept wordt ook wel distributed learning genoemd: leren van data die zich op vele verschillende plekken bevindt.

McCrory moedigt bedrijven en sectoren aan om over dergelijke concepten na te denken. “Je ziet dat mensen vaak pas beginnen met nadenken als ze tegen een beperking aan lopen. Je kunt dat beter voor zijn, want door het Jevons-effect neemt de hoeveelheid data exponentieel toe, terwijl de storagecapaciteit en rekenkracht die groei niet kunnen bijbenen. Als je pas naar oplossingen gaat zoeken tegen de tijd dat je tegen de beperkingen aan gaat lopen, ben je te laat.”

Datacenterlandschap met vier typen datacenters

Infrastructuurspecialisten zullen veel beter moeten nadenken over hun datacenterstrategie: op welke fysieke locaties heb ik datacentercapaciteit nodig? De tijd dat je genoeg had aan één datacenter met een uitwijkdatacenter als back-up ligt achter ons. Je zult per toepassing moeten bekijken welke data je waar wilt opslaan en verwerken, afhankelijk van latency, netwerkkosten en wet- en regelgeving. Het rapport ‘Data gravity en de impact op enterprise computing’ stelt dat in veel gevallen een landschap ontstaat dat bestaat uit vier typen datacenters:

1. on site: een server in een fabriek, op een olieveld, op een boerderij of in een autonoom rijdende auto;

2. microdatacenters: er ontstaan in de komende jaren netwerken van microdatacenters met een onderlinge afstand van maximaal tien kilometer. Deze vervullen een ultra-lokale colocatierol;

3. regionale datacenters: op een maximale afstand van vijftig kilometer tot de locatie waar de data nodig zijn. Deze datacenters bieden een grotere schaalbaarheid en blinken uit in beveiliging en hoge beschikbaarheid;

4. metrodatacenters: dit zijn de datacenters van de grote cloud en content providers in grootstedelijke gebieden die hoog scoren op de data gravity index.