Geavanceerde business intelligence kennen we onder namen als ‘machine learning’ en ‘artificial intelligence’. Data science is het wapen bij uitstek in de strijd om marktaandeel. Er zijn al spectaculaire verhalen te vertellen op dit gebied. Toch lukt het nog lang niet altijd om die ultieme stap te zetten van (big) data naar bruikbare inzichten die tot concrete bedrijfsresultaten leiden.

Het beeld van de daadwerkelijke stand van de hedendaagse BI-praktijken ziet er minder spectaculair uit dan enkele succesverhalen ons willen doen geloven. Weliswaar hebben de data en analytics besluitvormers van de meeste grote organisaties (72%) adequate toegang tot de benodigde data[1]. Maar het vereist diepgaande expertise om met de moderne BI-tools de juist data te vinden, de juiste vragen te stellen en om de resultaten correct te interpreteren op weg naar tastbare bedrijfsverbeteringen. De hypercomplexe BI-tools van de huidige generatie remmen in zekere zin de ontwikkelingen op het gebied van data science. Ze zijn niet ontwikkeld voor ‘non-data’ professionals. Informatiewerkers stuiten op een muur als zij de rijke datavisualisaties moeten interpreteren. Om tot inzichten te komen, moet nog altijd een langdurig en vaak onbetrouwbaar proces worden doorlopen. Bovendien werken de meeste tools gescheiden van systemen die de inzichten tot actie kunnen omzetten.

Geen datawarehouse

Maar er is hoop. Volgens de onderzoekers van Forrester kunnen organisaties AI-technieken en -tools hanteren om de waarde van BI te verhogen. Een van de opties is om data voor BI buiten het enterprise datawarehouses (EDW) om op te bouwen. Uiteraard blijven EDW’s een belangrijke rol spelen voor BI, zeker wanneer één versie van de waarheid een absolute vereiste is. Toch bewaren EDW’s doorgaans een kleine subset van alle enterprise data, omdat het bouwen en onderhouden van een EDW veel tijd en skills vereist. Professionals op het gebied van application development en delivery (AD&D) kunnen nu op basis van machine learning kijken naar geautomatiseerde data discovery, semantische data catalogi, data warehouse automatisering en data voorbereidingstools. Daarmee kunnen zij voortaan hun analytische datavoorraden bouwen. Toegegeven, deze dataverzamelingen creëren wellicht geen 100 procent accurate datamodellen en zijn misschien niet de ideale grondstof voor analyses die één versie van de waarheid vereisen. Daarentegen biedt het bedrijven wel de mogelijkheid om veel meer data te analyseren dan ze normaal gesproken doen.

Machine learning

Er is dus een gat tussen de huidige BI-technologieën en de groeiende behoefte aan inzichten uit data. Eén manier om dat gat te dichten, is het automatiseren van datavoorbereiding – profileren en conserveren. Deze functie – beschikbaar in veel BI-tools – vergt specifieke kennis en ervaring, die helaas niet voor het oprapen ligt. Ook hier bieden aparte machine learning tools uitkomst, door alle relevante databronnen te scannen, ze te profileren om typische waarden, uitzonderingen, waardereeksen enzovoort in iedere kolom vast te stellen. Verder kunnen we op een meer cognitieve, natuurlijke manier met computers interacteren en we kunnen het gebruik van geavanceerde analytics democratiseren. Daarmee wordt bedoeld dat basale machine learning en voorspellende analytics via ‘point-and-click tools’ beschikbaar komen, zodat iedereen een data scientist kan worden. Tot slot, naast het reeds vermelde omzeilen van het datawarehouse – zodat veel meer data beschikbaar komt voor analyse – helpt machine learning om tot inzichten te komen. Aangezien er altijd onvermoede inzichten verborgen liggen in data, kun je hierop tijdens de bouwfase van applicaties niet anticiperen. Deze kunnen dan via machine learning technologie alsnog worden opgepakt.

Omslag

In een artikel in Harvard Business Review[2] schrijft Walter Frick: “AI zal geen managers vervangen, maar managers die AI gebruiken zullen hen vervangen die dat niet doen.” Zo zullen BI-tools en teams die AI gebruiken de overhand krijgen. AD&D professionals die werken met BI moeten zich opmaken voor deze omslag. De op AI gebaseerde automatisering van data-ontdekking en datavoorbereiding zullen processen die nu nog handmatige codering vereisen, elimineren. Anderzijds brengen meer data en meer intuïtieve manieren om met data te werken een vloedgolf aan informatie en inzichten op gang. Iemand zal deze inzichten moeten interpreteren en beslissingen nemen om actie te ondernemen. Daarom voorspelt Forrester dat er de komende drie tot vijf jaar veel mensen die nog coderen in de BI plaats zullen maken voor analisten.

Onder de maat

Vier op de vijf data en analytics professionals wereldwijd zeggen dat hun organisatie meer data-gedreven wil worden en dat ze meer geavanceerde voorspellende analytics willen uitvoeren. Bijna net zoveel besluitvormers geven aan dat hun organisatie voorspellende analytics of AI-projecten hebben lopen of die van plan zijn op te starten[3]. Prachtig allemaal. Alleen zal weinig concreets voortkomen uit deze goede intenties zolang de disciplines van data science, IT en de business langs elkaar heen blijven werken. In de praktijk presteren veel projecten dan ook ver onder de maat. Dat heeft volgens Forrester een (of een combinatie) van de volgende oorzaken: 1) data science teams hebben zelden de bedrijfsbehoeften voor ogen, 2) het it-team ondersteunt de ontwikkeling of uitrol van het nieuwe model niet of onvoldoende en 3) het lukt de business niet om een project tot een succesvolle uitkomst te brengen.

Best practices

Bij succesvolle data science projecten werken de teams van data science, IT en de business effectief samen. Data science ontwerpt een business-eerst oplossing en IT verzorgt snel en adequaat datatoegang, levert de benodigde infrastructuur en tooling, rolt modellen uit naar productie en bouwt applicaties zodat eindgebruikers toegang krijgen tot de inzichten. De business is actief betrokken en gecommitteerd om de resultaten te implementeren. Om van dit ideale plaatje werkelijkheid te maken, moeten AD&D professionals de volgende vijf best practices navolgen (zie figuur 1).

1. Prioriteer projecten die zijn gericht op grote, goed gedefinieerde bedrijfsresultaten.

Nieuwe data science projecten kennen vele onbekende factoren. Is de benodigde data beschikbaar? Zal het de juiste uitkomsten voorspellen? Hierdoor heerst er doorgaans een houding van ‘we zien wel waar het schip strandt’. Door het om te draaien en bij aanvang helder de businesswaarde te formuleren die het project moet opleveren, kunnen teams beter de beperkte resources alloceren aan de belangrijkste problemen. Dit leidt vervolgens tot adoptie bij stakeholders en wanneer blijkt dat een project niet kan slagen, zal het snel worden gestopt. Succesvolle teams leggen heldere KPI’s vast die zijn bedoeld om het project te verbeteren en de impact tijdens het project te meten. Door snel stakeholders op te zoeken die (veel) zullen profiteren van het project, zal hun betrokkenheid toenemen. Zij zullen hartstochtelijker pleiten voor resources en de uiteindelijke oplossing adopteren. Projecten zonder begunstigden ontstijgen zelden het stadium van proof-of-concept.

2. Stel hybride, schaalbare teams samen.

Vraag aan een willekeurige organisatie welke vaardigheden een data scientist moet hebben, en je krijgt een onrealistisch lange opsomming. Kortom, bedrijven zoeken naar schepselen van mythische proporties. Het is realistischer en veel werkbaarder om een team samen te stellen met personen die beschikken over enkele van die vaardigheden. Bijvoorbeeld een data scientist die ook ervaring heeft als data engineer, of een data engineer die ook bekend is met ontwikkelen. Kies vervolgens in de leiderschapsrollen mensen die de werelden van de business, data science en IT kunnen overzien. Veel bedrijven ervaren dat deze hybride individuen productiever zijn dan specialisten. Hun kennis over diverse domeinen heen stelt hen namelijk in staat effectiever samen te werken en te innoveren.

3. Breng data science en data engineering samen

Snelle iteraties zijn zonder twijfel belangrijk binnen de life cycle van een data science project. Toch krijgen teams waar data engineering en data science als een tandem itereren snellere en betere resultaten. Blijven beide domeinen ver van elkaar verwijderd dan vertraagt iedere iteratie van het model. Dat leidt bovendien tot suboptimale prestaties van het model. Door ze samen te brengen, versterkt dit de prestaties van beide disciplines en het voorkomt een rivaliserende cultuur tussen beide ‘kampen’.

4. Bouw platforms om samenwerking te creëren, herwerk te verminderen en adoptie te versnellen.

Hoewel van kritisch belang wordt slechts een klein deel van de inspanning bij data science initiatieven besteed aan analyse en modelontwikkeling. De meeste tijd en energie gaat zitten in data discovery, het creëren van data pipelines, data voorbereiding enzovoort. Het komt nog regelmatig voor dat data science initiatieven voor elk van deze stappen het wiel opnieuw uitvinden, waarna de kennis in een silo opgesloten blijft. Daarom is het zo belangrijk om een platform te bouwen dat het delen van kennis en samenwerking bevordert. Machine learning platforms met visuele interfaces stellen teams in staat om bestaande data pipelines en machine learning modellen te onderhouden, te hergebruiken en te bouwen. Van oudsher betekent het naar productie brengen van een model, dat er nieuwe data pipelines moeten worden gebouwd en dat er nieuwe rekenkracht en opslag moet komen. Dit wordt steeds beter gestroomlijnd door bijvoorbeeld de ontwikkel- en productieomgevingen te standaardiseren, door het management van infrastructuur self-service te maken en door resources naar wens op en af te schalen.

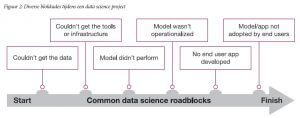

5. Breng iedere fase van de hele life cycle van het project in kaart.

Tijdens diverse momenten in de life cycle kan een data science project vastlopen (zie figuur 2). Het is des te pijnlijker en kostbaarder wanneer dat gebeurt met de finish in zicht. Tackle daarom de blokkades die verderop in het project kunnen optreden vroegtijdig. Plan bij aanvang hoe het model in productie wordt gebracht en hoe de gebruikers het resultaat zullen gebruiken. Plan tijdig oplossingen om blokkades te kunnen passeren en mocht dat niet lukken, pas dan het project aan. Coördineer dit vroegtijdig met stakeholders. Meestal schakelen data science teams IT pas in voor de uitrol wanneer ze klaar zijn met het ontwikkelen van een succesvol model. Het kan dan nog weken of maanden duren voordat de uitrol is gerealiseerd, wat de adoptie frustreert. Succesvolle teams brengen op voorhand in kaart welke ondersteuning ze wanneer nodig hebben van welke stakeholders. Dit doen ze voor iedere fase van het project. Ze benaderen iedere stakeholder ruim van tevoren, zodat de planning kan worden gecoördineerd om vertragingen en obstakels te vermijden.

Na de prachtige succesverhalen over data science – die er zeker ook zijn – zet de praktijk ons weer met beide benen op de grond. De mogelijkheden van geavanceerde BI zijn en blijven ongekend, maar om daadwerkelijk tot resultaten te komen, moet er nog flink wat werk worden verzet.

De voornaamste input van dit artikel komt van de volgende twee rapporten van onderzoeksbureau Forrester:

- AI Unlocks The Business Intelligence In BI, Continuous Improvement: The Business Intelligence Playbook, by Boris Evelson and Kjell Carlsson, Ph.D.

- Best Practices: Scaling Data Science Across The Enterprise Processes: The Customer Analytics Playbook, by Kjell Carlsson, Ph.D.

[1] Forrester onderzoeksrapport ‘AI Unlocks The Business Intelligence In BI’, maart 2018

[2] Walter Frick, “Why AI Can’t Write This Article (Yet),” Harvard Business Review, July 24, 2017

[3] Forrester onderzoeksrapport ‘Best Practices: Scaling Data Science Across The Enterprise Processes’, mei 2018