Grote taalmodellen (LLMs) veranderen de manier waarop bedrijven werken, maar hun ‘black box’-karakter zorgt vaak voor frustratie. Waarom maakt een model ineens een fout? Waarom gedraagt het zich onvoorspelbaar? Anthropic, bekend van het Claude-model, komt nu met een veelbelovende oplossing: een open-source circuit tracing tool die precies laat zien wat er intern in een taalmodel gebeurt, én waar het misgaat.

Tool van Anthropic

Deze tool stelt ontwikkelaars en onderzoekers in staat om onverklaarbare fouten en onverwacht gedrag in open-source modellen te analyseren. Hij helpt ook bij het verfijnen van modellen op een gedetailleerd niveau, gericht op specifieke interne functies. Het werkt op basis van een opkomend onderzoeksveld genaamd mechanistic interpretability, waarin de nadruk ligt op het begrijpen van de interne activaties van een model in plaats van alleen naar de input en output te kijken.

Attributiegrafieken

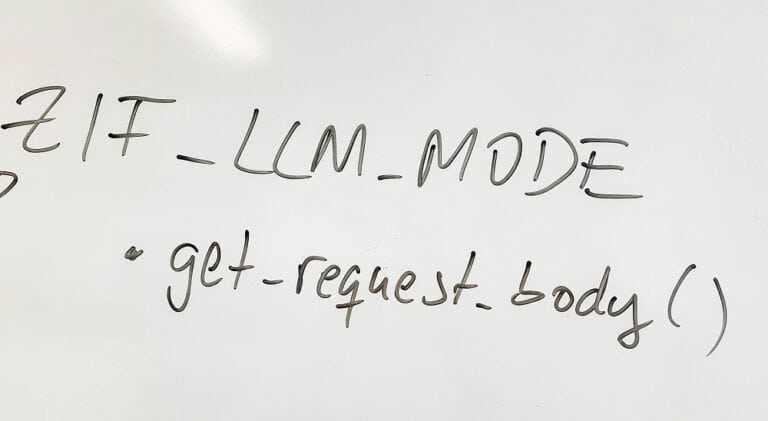

De circuit tracing tool genereert zogenoemde attributiegrafieken, die als een soort causale kaarten laten zien hoe interne ‘features’ – activatiepatronen die te herleiden zijn tot menselijke begrippen – met elkaar interacteren tijdens het verwerken van informatie. Zie het als een blauwdruk van het denkproces van het model. Nog belangrijker is dat onderzoekers hiermee zogeheten interventie-experimenten kunnen uitvoeren, waarbij interne processen worden aangepast om te zien hoe dat het gedrag van het model verandert. Dit maakt gericht debuggen van AI mogelijk.

Anthropic heeft de tool getest op onder meer de open modellen Gemma-2-2b en Llama-3.2-1b, en een Colab-notebook vrijgegeven zodat gebruikers meteen aan de slag kunnen. De tool werkt bovendien samen met Neuronpedia, een open platform voor experimenten met neurale netwerken.

Praktische uitdagingen

Hoewel het gebruik van deze tool gepaard gaat met praktische uitdagingen zoals hoge geheugenkosten en complexe visualisaties, is dit typerend voor baanbrekend onderzoek. Door de tool open te stellen, nodigt Anthropic de community uit om schaalbare en toegankelijke interpretatiehulpmiddelen te ontwikkelen.

Voor bedrijven betekent dit: niet langer blind varen op het gedrag van AI, maar gericht begrijpen waarom een model doet wat het doet, maar ook hoe dat eventueel verbeterd kan worden.