Dit weekend riep het College voor de Rechten van de Mens burgers op om het te melden als zij last hebben van discriminerende algoritmes. Een goede maar praktisch zeer ingewikkelde oproep om gehoor aan te geven, stelt Joris Krijger, Ethics en AI Officer bij De Volksbank. “Discriminatie in algoritmes is subtiel. En is op een paar duidelijke uitzonderingen na alleen vast te stellen aan de hand van meer data over het systeem.”

Geen toegang tot tentamen

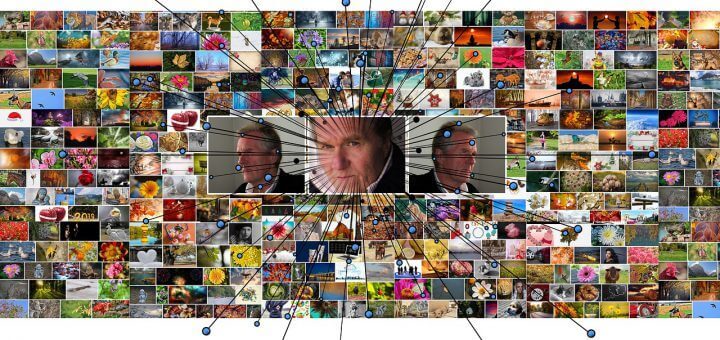

De aansporing vanuit het College ligt in het verlengde van het proces rond de mogelijk discriminerende gezichtsherkenningssoftware die de VU heeft ingezet bij online tentamens. Studente Robin Procornie kreeg geen toegang tot haar tentamen en beriep zich op haar eigen ervaring en academische papers die haar betoog ondersteunden om aannemelijk te maken dat de gezichtsherkenningssoftware een vooringenomenheid heeft waarmee mensen van kleur onterecht benadeeld worden.

Algoritmes moeten onderscheid maken

Het vaststellen van onrechtmatige discriminatie met een algoritme is echter complex, volgens Krijger. “Alle algoritmes ‘discrimineren’, ze worden immers juist ingezet om onderscheid te maken. En alle algoritmes maken fouten.”

Het verweer van de Universiteit laat die complexiteit goed zien, legt Krijger uit. “Volgens hen is het systeem ‘instabiel’ en hebben meerdere studenten daar last van gehad. De uitdaging wordt dan om aan te tonen dat mensen met een niet witte huidskleur, juist vanwege hun huidskleur, vaker zijn benadeeld door deze instabiliteit dan de andere studenten.”

Meer fouten bij mensen van kleur

In dit geval betreft het een direct zichtbare AI-toepassing waarvan in de literatuur al bekend is dat discriminerende vooringenomenheid een serieus probleem is. Van zelfrijdende auto’s tot opsporingssoftware, het maakt structureel meer fouten waar mensen van kleur door benadeeld worden.

Rol algoritmes vaak onzichtbaar

Maar veruit de meeste algoritmes die een rol spelen in ons dagelijks leven zijn niet of nauwelijks zichtbaar. Van de Belastingdienst tot onze verzekeraar, ze gebruiken algoritmes waar vooringenomenheden in kunnen zitten die voor een individuele burger niet merkbaar zal zijn. En als je al weet dat het een algoritme is dat jou benadeelt, moet je als burger sterk in je schoenen staan om aan te tonen dat de uitkomst én onterecht is én het resultaat is van een ongerechtvaardigd onderscheid dat het algoritme maakt op basis van jouw persoonlijke kenmerken.

Complexe wijze van discrimineren

Bovendien kan Kunstmatige Intelligentie op zeer complexe wijze discrimineren zonder dat het gevoelige data als huidskleur of geslacht nodig heeft. Krijger: “Dat er opgetreden moet worden tegen dit soort systemen is evident. Maar of burgers de meest geschikte groep vormen om dit probleem te signaleren lijkt mij zeer de vraag.”